This is the Linux app named DeepSpeed MII whose latest release can be downloaded as DeepSpeedMIIv0.0.8.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named DeepSpeed MII with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start the OnWorks Linux online or Windows online emulator or MACOS online emulator from this website.

- 5. From the OnWorks Linux OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application, install it and run it.

SCREENSHOTS

Ad

DeepSpeed MII

DESCRIPTION

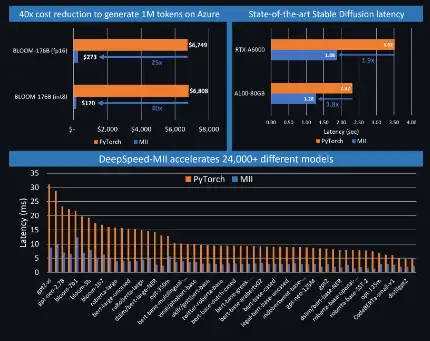

MII makes low-latency and high-throughput inference possible, powered by DeepSpeed. The Deep Learning (DL) open-source community has seen tremendous growth in the last few months. Incredibly powerful text generation models such as the Bloom 176B, or image generation model such as Stable Diffusion are now available to anyone with access to a handful or even a single GPU through platforms such as Hugging Face. While open-sourcing has democratized access to AI capabilities, their application is still restricted by two critical factors: inference latency and cost. DeepSpeed-MII is a new open-source python library from DeepSpeed, aimed towards making low-latency, low-cost inference of powerful models not only feasible but also easily accessible. MII offers access to the highly optimized implementation of thousands of widely used DL models. MII-supported models achieve significantly lower latency and cost compared to their original implementation.

Features

- MII offers access to highly optimized implementation of thousands of widely used DL models

- MII supported models achieve significantly lower latency and cost compared to their original implementation

- MII leverages an extensive set of optimizations from DeepSpeed-Inference such as deepfusion for transformers

- State-of-the-art performance

- MII supports low-cost deployment of these models both on-premises and on Azure via AML with just a few lines of codes

- Automated tensor-slicing for multi-GPU inference, on-the-fly quantization with ZeroQuant

Programming Language

Python

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/deepspeed-mii.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.