This is the Linux app named apache spark data pipeline osDQ whose latest release can be downloaded as osdq-spark_0.0.1.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named apache spark data pipeline osDQ with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start the OnWorks Linux online or Windows online emulator or MACOS online emulator from this website.

- 5. From the OnWorks Linux OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application, install it and run it.

SCREENSHOTS

Ad

apache spark data pipeline osDQ

DESCRIPTION

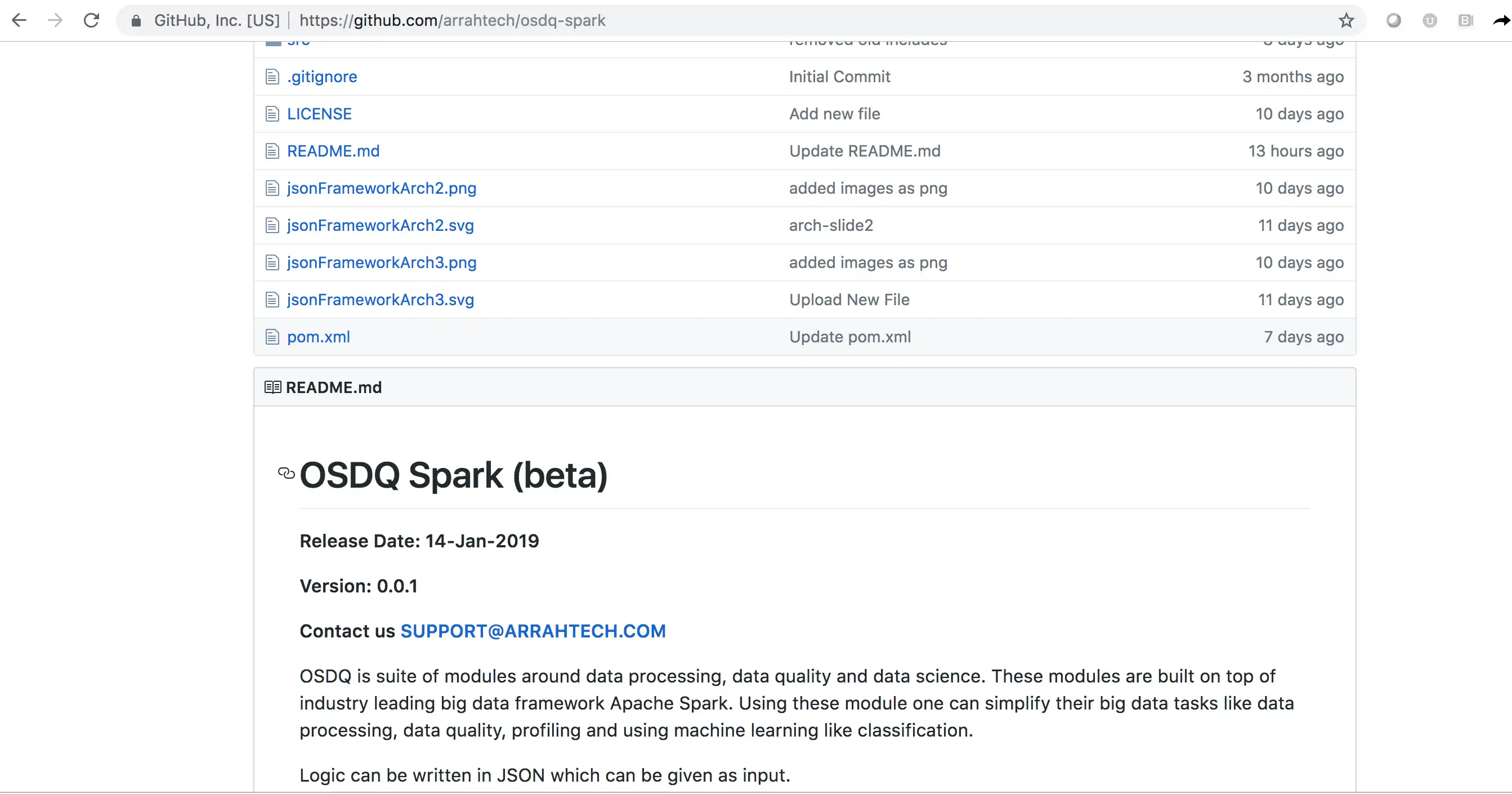

This is an offshoot project of open source data quality (osDQ) project https://sourceforge.net/projects/dataquality/

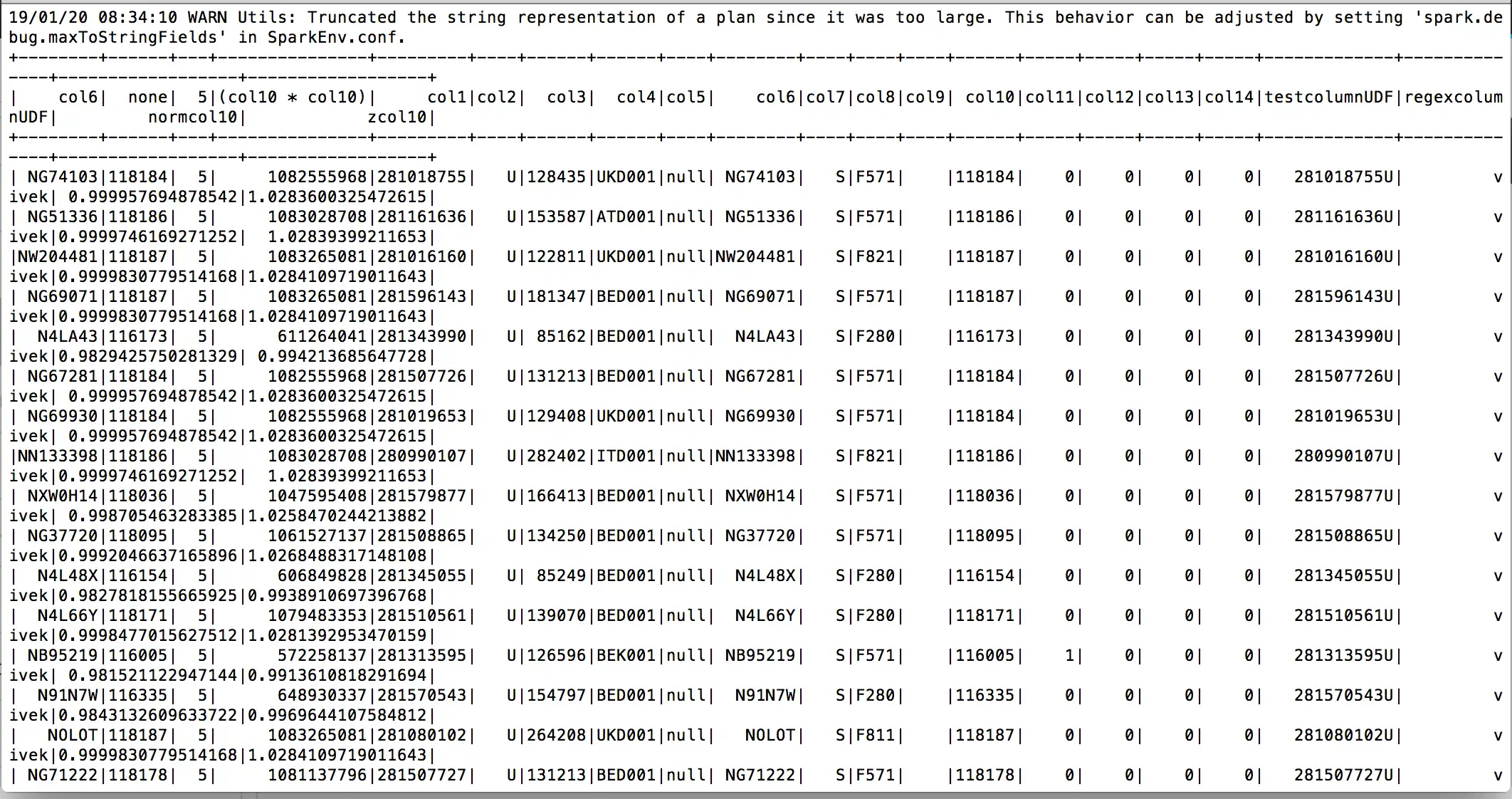

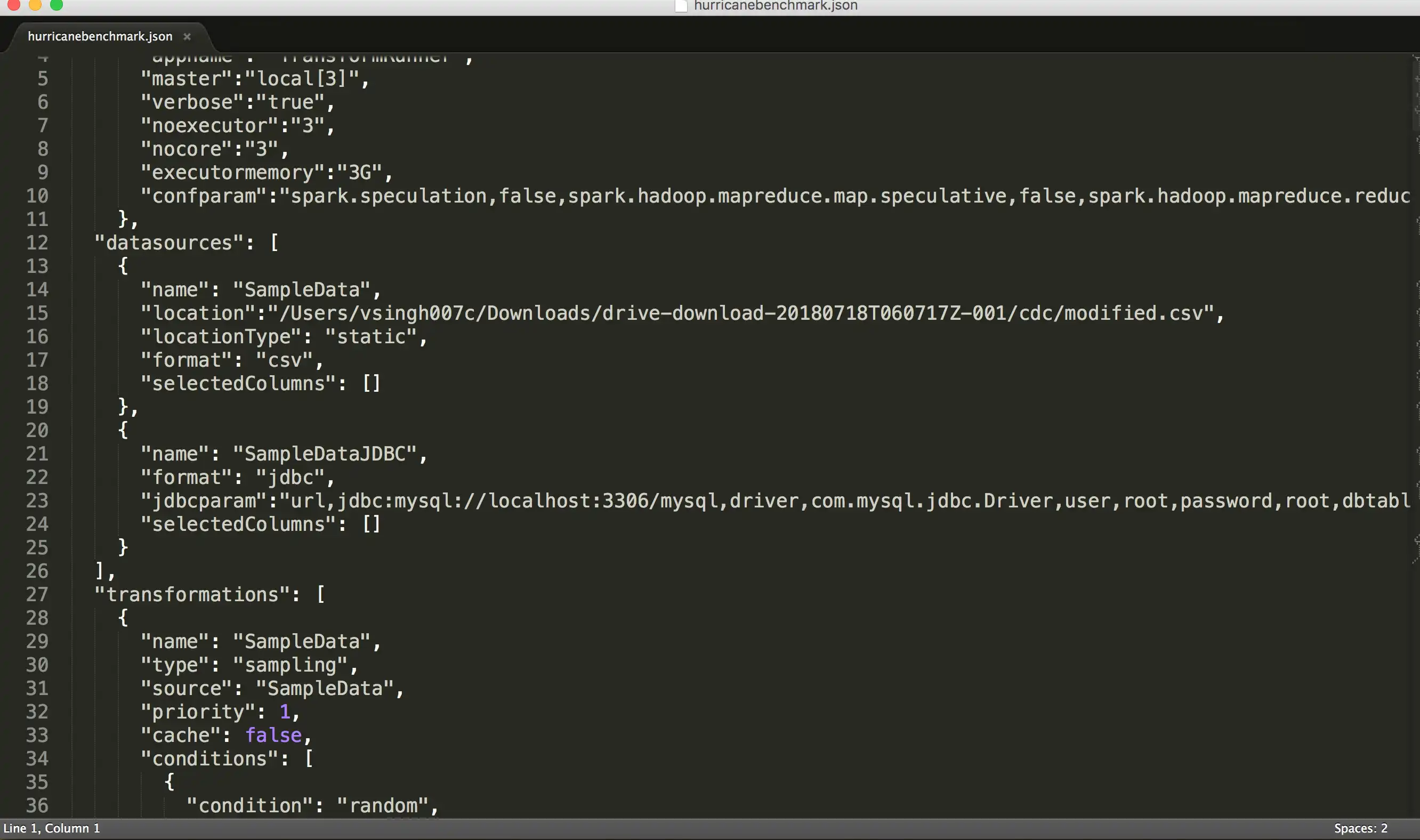

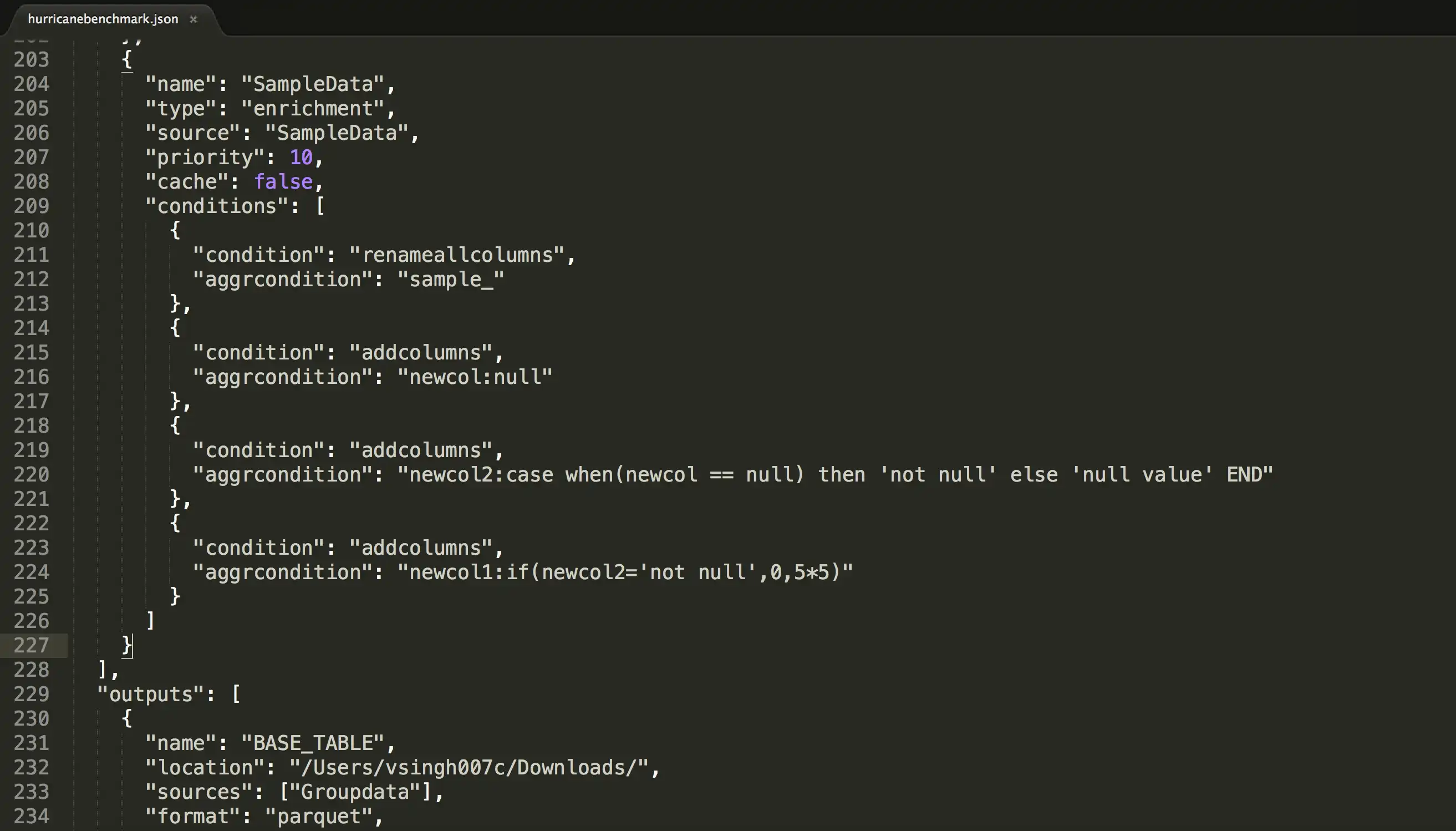

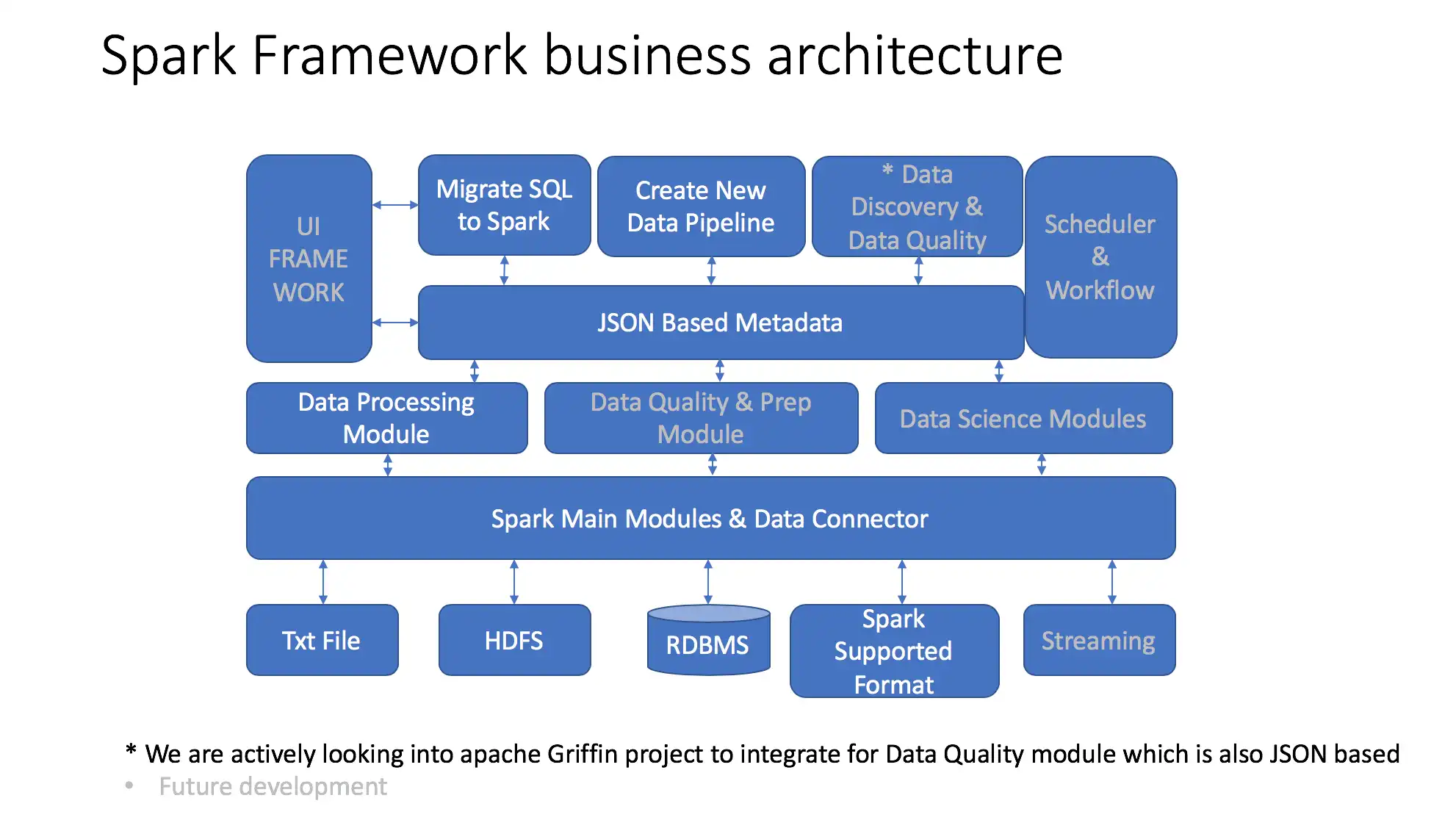

This sub project will create apache spark based data pipeline where JSON based metadata (file) will be used to run data processing , data pipeline , data quality and data preparation and data modeling features for big data. This uses java API of apache spark. It can run in local mode also.

Get json example at https://github.com/arrahtech/osdq-spark

How to run

Unzip the zip file

Windows : java -cp .\lib\*;osdq-spark-0.0.1.jar org.arrah.framework.spark.run.TransformRunner -c .\example\samplerun.json

Mac UNIX

java -cp ./lib/*:./osdq-spark-0.0.1.jar org.arrah.framework.spark.run.TransformRunner -c ./example/samplerun.json

For those on windows, you need to have hadoop distribtion unzipped on local drive and HADOOP_HOME set. Also copy winutils.exe from here into HADOOP_HOME\bin

Features

- Create data pipeline like using Join, Filter, Aggregate, Case statement

- Use Data Quality - replace, drop, join,

- Data Profiling, Column base Profiling

- Fuzzy Join - cosine distance and others

- classification and sampling - random forest, Multi class neural network

- data normalization - zscore, std deviation, ratio score,

- Sampling Random, Stratified , Key based

Audience

Information Technology, Other Audience, Architects

User interface

Console/Terminal

Programming Language

Java, Scala

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/apache-spark-osdq/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.