This is the Windows app named Alpaca.cpp whose latest release can be downloaded as 9116ae9.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named Alpaca.cpp with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start any OS OnWorks online emulator from this website, but better Windows online emulator.

- 5. From the OnWorks Windows OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application and install it.

- 7. Download Wine from your Linux distributions software repositories. Once installed, you can then double-click the app to run them with Wine. You can also try PlayOnLinux, a fancy interface over Wine that will help you install popular Windows programs and games.

Wine is a way to run Windows software on Linux, but with no Windows required. Wine is an open-source Windows compatibility layer that can run Windows programs directly on any Linux desktop. Essentially, Wine is trying to re-implement enough of Windows from scratch so that it can run all those Windows applications without actually needing Windows.

SCREENSHOTS

Ad

Alpaca.cpp

DESCRIPTION

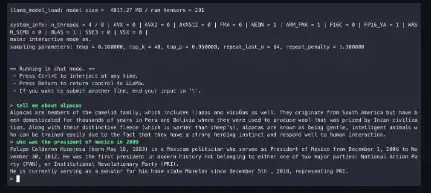

Run a fast ChatGPT-like model locally on your device. This combines the LLaMA foundation model with an open reproduction of Stanford Alpaca a fine-tuning of the base model to obey instructions (akin to the RLHF used to train ChatGPT) and a set of modifications to llama.cpp to add a chat interface. Download the zip file corresponding to your operating system from the latest release. The weights are based on the published fine-tunes from alpaca-lora, converted back into a PyTorch checkpoint with a modified script and then quantized with llama.cpp the regular way.

Features

- Run a fast ChatGPT-like model locally on your device

- If you have more than 10GB of RAM, you can use the higher quality 13B model

- Combines the LLaMA foundation model with an open reproduction of Stanford Alpaca

- The weights are based on the published fine-tunes from alpaca-lora,

- You can add other launch options

- You can now type to the AI in the terminal and it will reply

Programming Language

C++, C

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/alpaca-cpp.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.