This is the Windows app named ChatLLM Web whose latest release can be downloaded as v1.0.0.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named ChatLLM Web with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start any OS OnWorks online emulator from this website, but better Windows online emulator.

- 5. From the OnWorks Windows OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application and install it.

- 7. Download Wine from your Linux distributions software repositories. Once installed, you can then double-click the app to run them with Wine. You can also try PlayOnLinux, a fancy interface over Wine that will help you install popular Windows programs and games.

Wine is a way to run Windows software on Linux, but with no Windows required. Wine is an open-source Windows compatibility layer that can run Windows programs directly on any Linux desktop. Essentially, Wine is trying to re-implement enough of Windows from scratch so that it can run all those Windows applications without actually needing Windows.

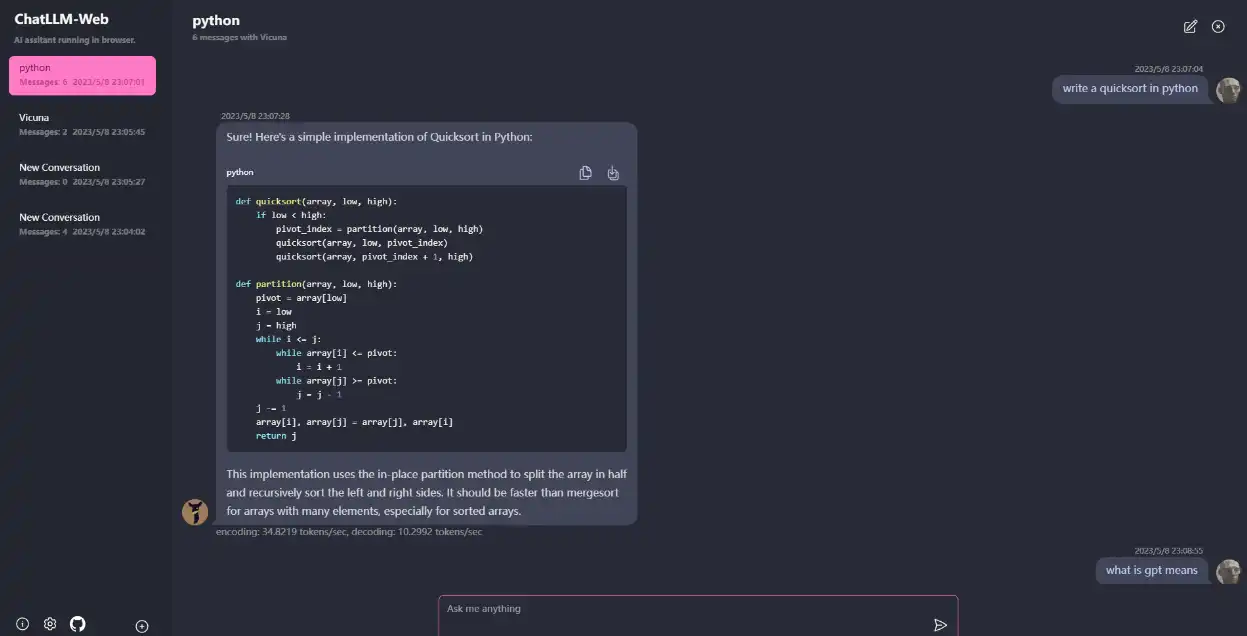

SCREENSHOTS

Ad

ChatLLM Web

DESCRIPTION

Chat with LLM like Vicuna totally in your browser with WebGPU, safely, privately, and with no server. Powered By web-llm. To use this app, you need a browser that supports WebGPU, such as Chrome 113 or Chrome Canary. Chrome versions ≤ 112 are not supported. You will need a GPU with about 6.4GB of memory. If your GPU has less memory, the app will still run, but the response time will be slower. The first time you use the app, you will need to download the model. For the Vicuna-7b model that we are currently using, the download size is about 4GB. After the initial download, the model will be loaded from the browser cache for faster usage.

Features

- Everything runs inside the browser with no server support and is accelerated with WebGPU

- Model runs in a web worker, ensuring that it doesn't block the user interface and providing a seamless experience

- Easy to deploy for free with one-click on Vercel in under 1 minute, then you get your own ChatLLM Web

- Model caching is supported, so you only need to download the model once

- Multi-conversation chat, with all data stored locally in the browser for privacy

- Markdown and streaming response support: math, code highlighting, etc.

Programming Language

JavaScript

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/chatllm-web.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.