This is the Windows app named TensorRT whose latest release can be downloaded as TensorRTOSSv9.1.0sourcecode.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named TensorRT with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start any OS OnWorks online emulator from this website, but better Windows online emulator.

- 5. From the OnWorks Windows OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application and install it.

- 7. Download Wine from your Linux distributions software repositories. Once installed, you can then double-click the app to run them with Wine. You can also try PlayOnLinux, a fancy interface over Wine that will help you install popular Windows programs and games.

Wine is a way to run Windows software on Linux, but with no Windows required. Wine is an open-source Windows compatibility layer that can run Windows programs directly on any Linux desktop. Essentially, Wine is trying to re-implement enough of Windows from scratch so that it can run all those Windows applications without actually needing Windows.

SCREENSHOTS

Ad

TensorRT

DESCRIPTION

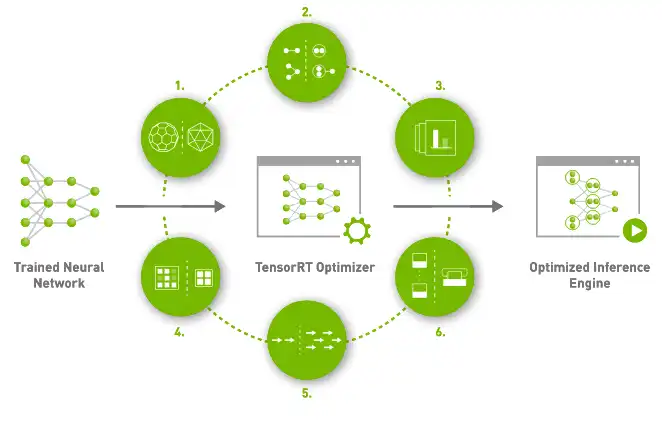

NVIDIA® TensorRT™ is an SDK for high-performance deep learning inference. It includes a deep learning inference optimizer and runtime that delivers low latency and high throughput for deep learning inference applications. TensorRT-based applications perform up to 40X faster than CPU-only platforms during inference. With TensorRT, you can optimize neural network models trained in all major frameworks, calibrate for lower precision with high accuracy, and deploy to hyperscale data centers, embedded, or automotive product platforms. TensorRT is built on CUDA®, NVIDIA’s parallel programming model, and enables you to optimize inference leveraging libraries, development tools, and technologies in CUDA-X™ for artificial intelligence, autonomous machines, high-performance computing, and graphics. With new NVIDIA Ampere Architecture GPUs, TensorRT also leverages sparse tensor cores providing an additional performance boost.

Features

- TensorRT provides INT8 using Quantization Aware Training and Post Training Quantization

- Production deployments of deep learning inference applications such as video streaming, speech recognition, recommendation, etc.

- Reduced precision inference significantly reduces application latency

- With TensorRT, developers can focus on creating novel AI-powered applications rather than performance tuning for inference deployment

- Maximizes throughput with FP16 or INT8 by quantizing models while preserving accuracy

- Optimizes use of GPU memory and bandwidth by fusing nodes in a kernel

Programming Language

C++

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/tensorrt.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.