This is the Linux app named MedicalGPT whose latest release can be downloaded as v1.6.0sourcecode.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named MedicalGPT with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start the OnWorks Linux online or Windows online emulator or MACOS online emulator from this website.

- 5. From the OnWorks Linux OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application, install it and run it.

SCREENSHOTS

Ad

MedicalGPT

DESCRIPTION

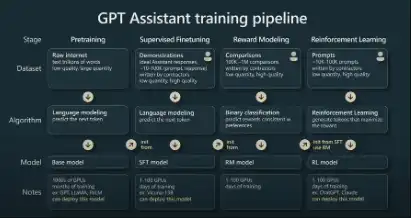

MedicalGPT training medical GPT model with ChatGPT training pipeline, implementation of Pretraining, Supervised Finetuning, Reward Modeling and Reinforcement Learning. MedicalGPT trains large medical models, including secondary pre-training, supervised fine-tuning, reward modeling, and reinforcement learning training.

Features

- The first stage: PT (Continue PreTraining) incremental pre-training, pre-training the GPT model twice on massive domain document data to inject domain knowledge

- The second stage: SFT (Supervised Fine-tuning) has supervised fine-tuning, constructs an instruction fine-tuning data set, and performs instruction fine-tuning on the basis of the pre-training model to align instruction intentions

- The third stage: RM (Reward Model) reward model modeling, constructing a human preference ranking data set, training the reward model to align human preferences, mainly the "HHH" principle, specifically "helpful, honest, harmless"

- The fourth stage: RL (Reinforcement Learning) is based on human feedback reinforcement learning (RLHF), using the reward model to train the SFT model, and the generation model uses rewards or penalties to update its strategy in order to generate higher quality, more in line with human preferences

- We provide a simple Gradio-based interactive web interface

- After the training is complete, now we load the trained model to verify the effect of the model generating text

Programming Language

Python

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/medicalgpt.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.