This is the Linux app named Fairseq whose latest release can be downloaded as v0.10.2.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named Fairseq with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start the OnWorks Linux online or Windows online emulator or MACOS online emulator from this website.

- 5. From the OnWorks Linux OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application, install it and run it.

SCREENSHOTS

Ad

Fairseq

DESCRIPTION

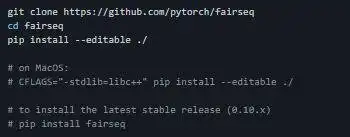

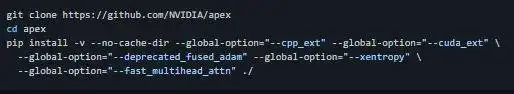

Fairseq(-py) is a sequence modeling toolkit that allows researchers and developers to train custom models for translation, summarization, language modeling and other text generation tasks. We provide reference implementations of various sequence modeling papers. Recent work by Microsoft and Google has shown that data parallel training can be made significantly more efficient by sharding the model parameters and optimizer state across data parallel workers. These ideas are encapsulated in the new FullyShardedDataParallel (FSDP) wrapper provided by fairscale. Fairseq can be extended through user-supplied plug-ins. Models define the neural network architecture and encapsulate all of the learnable parameters. Criterions compute the loss function given the model outputs and targets. Tasks store dictionaries and provide helpers for loading/iterating over Datasets, initializing the Model/Criterion and calculating the loss.

Features

- Multi-GPU training on one machine or across multiple machines (data and model parallel)

- Fast generation on both CPU and GPU with multiple search algorithms implemented

- Gradient accumulation enables training with large mini-batches even on a single GPU

- Mixed precision training (trains faster with less GPU memory on NVIDIA tensor cores)

- Easily register new models, criterions, tasks, optimizers and learning rate schedulers

- Flexible configuration based on Hydra allowing a combination of code, command-line and file based configuration

Programming Language

Python

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/fairseq.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.