This is the Windows app named llama2-webui whose latest release can be downloaded as v0.1.14Release.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named llama2-webui with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start any OS OnWorks online emulator from this website, but better Windows online emulator.

- 5. From the OnWorks Windows OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application and install it.

- 7. Download Wine from your Linux distributions software repositories. Once installed, you can then double-click the app to run them with Wine. You can also try PlayOnLinux, a fancy interface over Wine that will help you install popular Windows programs and games.

Wine is a way to run Windows software on Linux, but with no Windows required. Wine is an open-source Windows compatibility layer that can run Windows programs directly on any Linux desktop. Essentially, Wine is trying to re-implement enough of Windows from scratch so that it can run all those Windows applications without actually needing Windows.

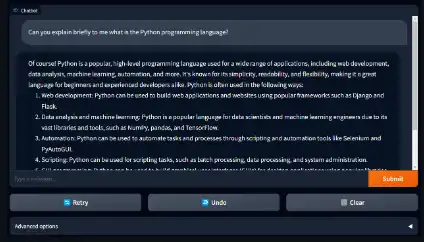

SCREENSHOTS

Ad

llama2-webui

DESCRIPTION

Running Llama 2 with gradio web UI on GPU or CPU from anywhere (Linux/Windows/Mac).

Features

- Supporting all Llama 2 models (7B, 13B, 70B, GPTQ, GGML) with 8-bit, 4-bit mode

- Use llama2-wrapper as your local llama2 backend for Generative Agents/Apps; colab example

- Run OpenAI Compatible API on Llama2 models

- Supporting models: Llama-2-7b/13b/70b, all Llama-2-GPTQ, all Llama-2-GGML

- Supporting model backends: tranformers, bitsandbytes(8-bit inference), AutoGPTQ(4-bit inference), llama.cpp

- Demos: Run Llama2 on MacBook Air; Run Llama2 on free Colab T4 GPU

Programming Language

Python

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/llama2-webui.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.