This is the Windows app named Web LLM whose latest release can be downloaded as v0.2.0.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named Web LLM with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start any OS OnWorks online emulator from this website, but better Windows online emulator.

- 5. From the OnWorks Windows OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application and install it.

- 7. Download Wine from your Linux distributions software repositories. Once installed, you can then double-click the app to run them with Wine. You can also try PlayOnLinux, a fancy interface over Wine that will help you install popular Windows programs and games.

Wine is a way to run Windows software on Linux, but with no Windows required. Wine is an open-source Windows compatibility layer that can run Windows programs directly on any Linux desktop. Essentially, Wine is trying to re-implement enough of Windows from scratch so that it can run all those Windows applications without actually needing Windows.

SCREENSHOTS

Ad

Web LLM

DESCRIPTION

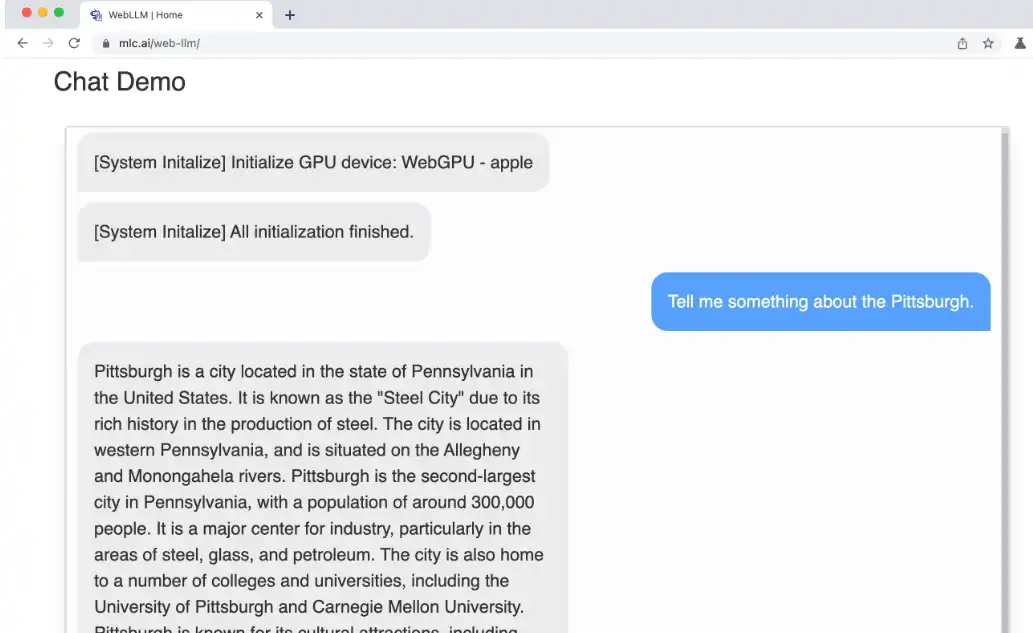

WebLLM is a modular, customizable javascript package that directly brings language model chats directly onto web browsers with hardware acceleration. Everything runs inside the browser with no server support and is accelerated with WebGPU. We can bring a lot of fun opportunities to build AI assistants for everyone and enable privacy while enjoying GPU acceleration. WebLLM offers a minimalist and modular interface to access the chatbot in the browser. The WebLLM package itself does not come with UI, and is designed in a modular way to hook to any of the UI components. The following code snippet demonstrates a simple example that generates a streaming response on a webpage.

Features

- WebLLM comes with API support for WebWorker so you can hook the generation process into a separate worker thread so that the compute in the webworker won't disrupt the UI

- You can find a complete a complete chat app example in examples/simple-chat

- WebLLM works as a companion project of MLC LLM

- It reuses the model artifact and builds flow of MLC LLM

- Build WebLLM Package From Source

- WebLLM package is a web runtime designed for MLC LLM

Programming Language

TypeScript

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/web-llm.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.