This is the Windows app named llm whose latest release can be downloaded as llm-cli-x86_64-pc-windows-msvc.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named llm with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start any OS OnWorks online emulator from this website, but better Windows online emulator.

- 5. From the OnWorks Windows OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application and install it.

- 7. Download Wine from your Linux distributions software repositories. Once installed, you can then double-click the app to run them with Wine. You can also try PlayOnLinux, a fancy interface over Wine that will help you install popular Windows programs and games.

Wine is a way to run Windows software on Linux, but with no Windows required. Wine is an open-source Windows compatibility layer that can run Windows programs directly on any Linux desktop. Essentially, Wine is trying to re-implement enough of Windows from scratch so that it can run all those Windows applications without actually needing Windows.

SCREENSHOTS

Ad

llm

DESCRIPTION

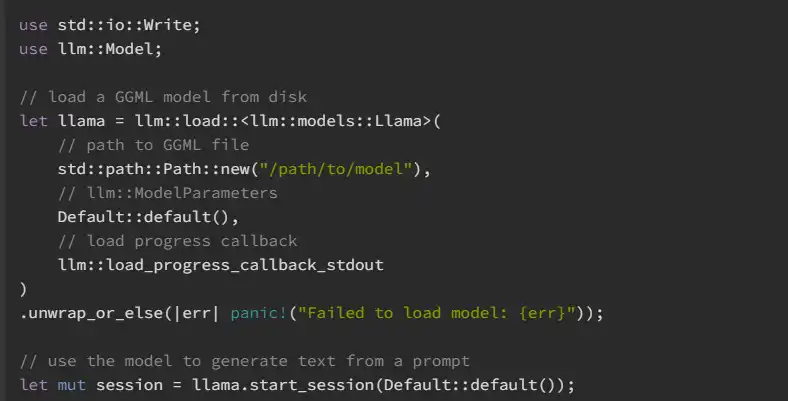

llm is an ecosystem of Rust libraries for working with large language models - it's built on top of the fast, efficient GGML library for machine learning. The primary entry point for developers is the llm crate, which wraps the llm-base and the supported model crates. Documentation for the released version is available on Docs.rs. For end-users, there is a CLI application, llm-cli, which provides a convenient interface for interacting with supported models. Text generation can be done as a one-off based on a prompt, or interactively, through REPL or chat modes. The CLI can also be used to serialize (print) decoded models, quantize GGML files, or compute the perplexity of a model. It can be downloaded from the latest GitHub release or by installing it from crates.io.

Features

- llm is powered by the ggml tensor library, and aims to bring the robustness and ease of use of Rust to the world of large language models

- This project depends on Rust v1.65.0 or above and a modern C toolchain

- The llm library is engineered to take advantage of hardware accelerators such as cuda and metal for optimized performance

- To enable llm to harness these accelerators, some preliminary configuration steps are necessary

- The easiest way to get started with llm-cli is to download a pre-built executable from a released version of llm

- By default, llm builds with support for remotely fetching the tokenizer from Hugging Face's model hub

Programming Language

Rust

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/llm.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.