This is the Linux app named SageMaker Inference Toolkit whose latest release can be downloaded as v1.10.0.zip. It can be run online in the free hosting provider OnWorks for workstations.

Download and run online this app named SageMaker Inference Toolkit with OnWorks for free.

Follow these instructions in order to run this app:

- 1. Downloaded this application in your PC.

- 2. Enter in our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 3. Upload this application in such filemanager.

- 4. Start the OnWorks Linux online or Windows online emulator or MACOS online emulator from this website.

- 5. From the OnWorks Linux OS you have just started, goto our file manager https://www.onworks.net/myfiles.php?username=XXXXX with the username that you want.

- 6. Download the application, install it and run it.

SCREENSHOTS

Ad

SageMaker Inference Toolkit

DESCRIPTION

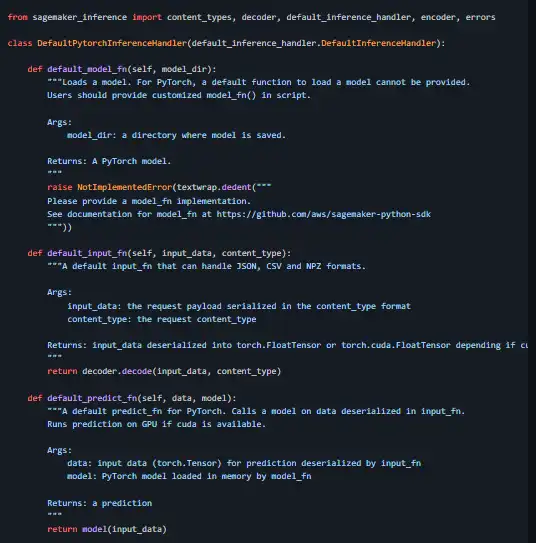

Serve machine learning models within a Docker container using Amazon SageMaker. Amazon SageMaker is a fully managed service for data science and machine learning (ML) workflows. You can use Amazon SageMaker to simplify the process of building, training, and deploying ML models. Once you have a trained model, you can include it in a Docker container that runs your inference code. A container provides an effectively isolated environment, ensuring a consistent runtime regardless of where the container is deployed. Containerizing your model and code enables fast and reliable deployment of your model. The SageMaker Inference Toolkit implements a model serving stack and can be easily added to any Docker container, making it deployable to SageMaker. This library's serving stack is built on Multi Model Server, and it can serve your own models or those you trained on SageMaker using machine learning frameworks with native SageMaker support.

Features

- This library's serving stack is built on Multi Model Server

- Serve your own models or those you trained on SageMaker using machine learning frameworks with native SageMaker support

- If you use a prebuilt SageMaker Docker image for inference, this library may already be included

- Implement a handler service that is executed by the model server

- Implement a serving entrypoint, which starts the model server

- This library is licensed under the Apache 2.0 License

Programming Language

Python

Categories

This is an application that can also be fetched from https://sourceforge.net/projects/sagemaker-infer-toolkit.mirror/. It has been hosted in OnWorks in order to be run online in an easiest way from one of our free Operative Systems.